- Fuk AI

- Posts

- [ FukAI ][ Số 05 ] AI có thực sự nghĩ không ?

[ FukAI ][ Số 05 ] AI có thực sự nghĩ không ?

Large Reasoning Model đột phá hay trò gimmick ?

[ AI có thực sự nghĩ không ? ]

[ Nghiên cứu của Apple ]

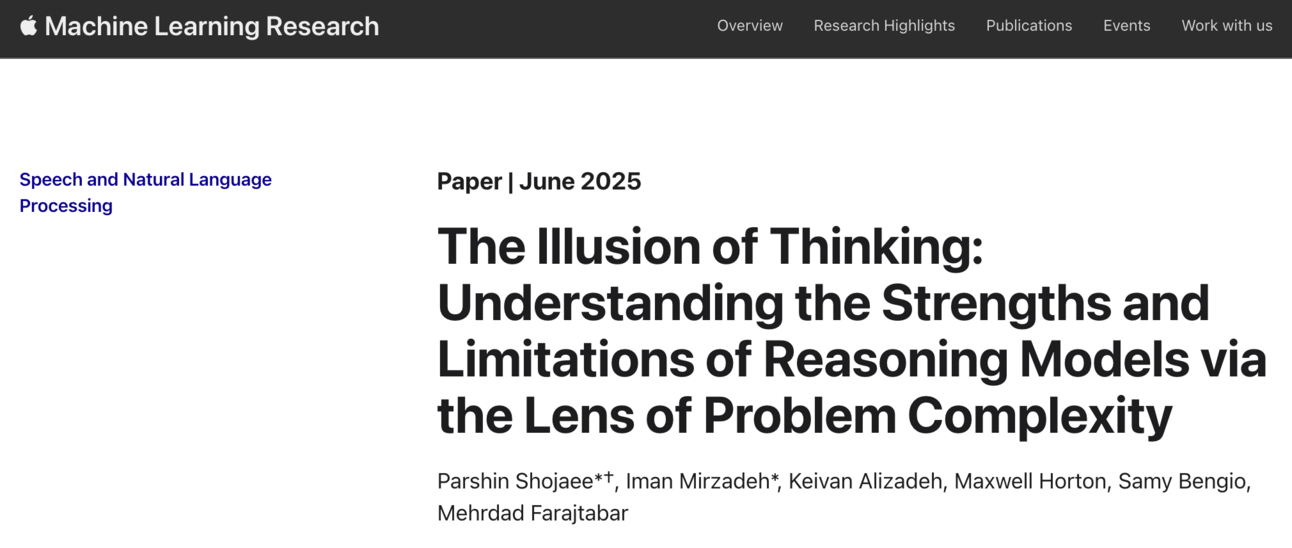

Tuần này Apple có release một cái nghiên cứu gây xôn xao tên là “Ảo tưởng về tư duy: Hiểu được điểm mạnh và hạn chế của các Mô Hình AI Lý Luận thông qua việc thử nghiệm với các Vấn Đề có Sự Phức Tạp khác nhau”.

Nghiên cứu này ngắn gọn là thực hiện một loạt thử nghiệm lý luận dạng game Tư Duy Lý Luận mà con người hay phải động não logic để giải ví dụ như game Tháp Hà Nội và đánh giá xem các mô hình AI Lý Luận (reasoning model) có Tư Duy Logic như con người không ?

Kết quả của nghiên cứu này là đám mô hình AI Reasoning Model là bố láo hết, chúng nó không có khả năng Tư Duy Lý Luận giống con người do khi nhóm nghiên cứu tăng độ phức tạp của vấn đề cần logic lên càng cao thì mô hình càng thất bại trong việc lý luận tìm ra giải pháp, ví dụ đơn giản là nhóm nghiên cứu gia tăng số lượng đĩa và cột trong game Tháp Hà Nội là đám AI Reasoning Model suy luận tùm bậy liền 😊

[ CHÚ Ý: Nội dung dưới đây là khoa học dễ hiểu cho bình dân đọc hiểu, nhiều khái niệm được giản lược, không đảm bảo tính chính xác học thuật ]

[ Bản chất của AI LLM ]

Nội dung giải thích này mình viết từ tháng 1.2023 lúc ChatGPT gây sốt trên toàn cầu rồi. Nhưng có vẻ lâu rồi mấy thứ ảo ảo về AI nó lấp mie mất, nên phải viết lại thôi.

Mô hình AI Ngôn Ngữ Lớn (Large Language Model) bản chất chỉ là một chương trình máy tính (vì nó chạy trên máy tính 🙃), nó được lập trình - thiết kế bởi các nhà khoa học ngành Máy Học (Machine Learning), với mục đích là nhận “đầu vào” là Văn Bản (Input Text) và xử lý cái mie gì đó bên trong chương trình AI đó rồi Sinh ra một đoạn chữ nối tiếp đoạn chữ (Input Text) mà chúng ta đưa vào “đầu vào”; để dễ hiểu có thể tưởng tượng AI LLM nó giống chương trình máy tính Microsoft Word nhưng xịn hơn ngầu hơn khi bạn chỉ việc viết một dòng chữ và nó tự viết nối tiếp dòng chữ đó thành đoạn văn có ý nghĩa.

Chương trình AI LLM này được tạo ra bằng cách làm những việc sau:

Cào toàn bộ văn bản có thể truy cập được công cộng trên Internet như báo chí online, websites, blog, ebook …

Nén toàn bộ văn bản đã được cào từ Internet về vô một file nén giống file zip 🙃

Lập trình thêm tính năng tìm kiếm đoạn văn bản bất kỳ trong file zip và lấy ra mấy chữ xung quanh đoạn văn bản được tìm thấy.

Vì chắc chắn có rất nhiều đoạn văn bản chứa đoạn văn bản mà chúng ta tìm kiếm trong file zip (dễ hiểu mà cào dữ liệu từ toàn internet thì phải có trùng nhau thôi), nên phải lập trình thêm một tính năng nữa là xếp hạng coi đoạn văn bản nào có vẻ khớp nhất với đoạn văn bản mà chúng ta tìm, rồi bốc nó ra làm kết quả 🙃

=> Yes, ngắn gọn thì AI LLM chả khác méo gì … Google Search 😁

Rồi vấn đề là cái mục số 4 đó, cái thuật toán xếp hạng kết quả tìm kiếm để tìm ra cái thích hợp nhất đó, nó dựa trên XÁC XUẤT (Probability) để lựa coi cái kết quả nào thích hợp nhất, mà XÁC XUẤT là thứ luôn chứa bên trong nó tính NGẪU NHIÊN (Randomness). Rồi dễ hiểu là Thuật toán để chọn ra kết quả thích hợp của chương trình AI LLM nó có tính chất NGẪU NHIÊN nên 10 lần đi tìm một đoạn văn bản trong file zip thì 10 lần kết quả sẽ … “khác nhau” :))))) đây chính là nguyên do sinh ra một “hiện tượng” trong AI mà chúng ta hay gọi là “ẢO TƯỞNG” (Hallucination) tức là AI hay CHẾ ra những thứ không có thật (nhưng có trong dữ liệu được cào từ Internet về nhưng bị trộn lẫn vào nhau trong quá trình NÉN file ZIP AI LLM). Đây là hệ quả không tránh khỏi vì chương trình AI LLM xài thuật toán Xác Xuất để chọn ra kết quả tìm kiếm thích hợp 🙂

Tóm lại AI LLM là một chương trình máy tính có chức năng tìm kiếm một văn bản trong một file zip to thiệt to chứa toàn bộ văn bản trên internet và chọn ra kết quả thích hợp nhất với câu truy vấn tìm kiếm bằng phương pháp chọn ngẫu nhiên :)))

[ Bản chất của việc “Tư Duy Suy Luận” (Reasoning) trong AI Reasoning Model ]

Tháng 8.2024 giới làm AI có một hướng làm AI mới là các mô hình AI Suy Luận (Large Reasoning Model - LRM). Các AI LRM bản chất là các AI LLM được nén thêm vô file zip các dữ liệu về “suy luận từng bước trước khi kết luận”.

Cơ bản cách tạo nên AI LRM phần lớn phụ thuộc vào một công ty tên Scale AI do một bạn founder người Mỹ gốc Hoa sinh năm 1997 thành lập :))) công ty này vừa được Meta của Mark Zuck mua lại tới 41% và bạn này về Meta AI để phục vụ cuộc đua tạo ra AGI :)))

Rồi nói tiếp về cách tạo nên AI Large Reasoning Model như sau:

Thuê công ty Scale AI, công ty này chuyên thuê NGƯỜI từ Trung Quốc, Việt Nam, Ấn Độ, Đông Nam Á…, thực hiện công việc tạo data huấn luyện AI bằng tay với giá công rẻ mạt.

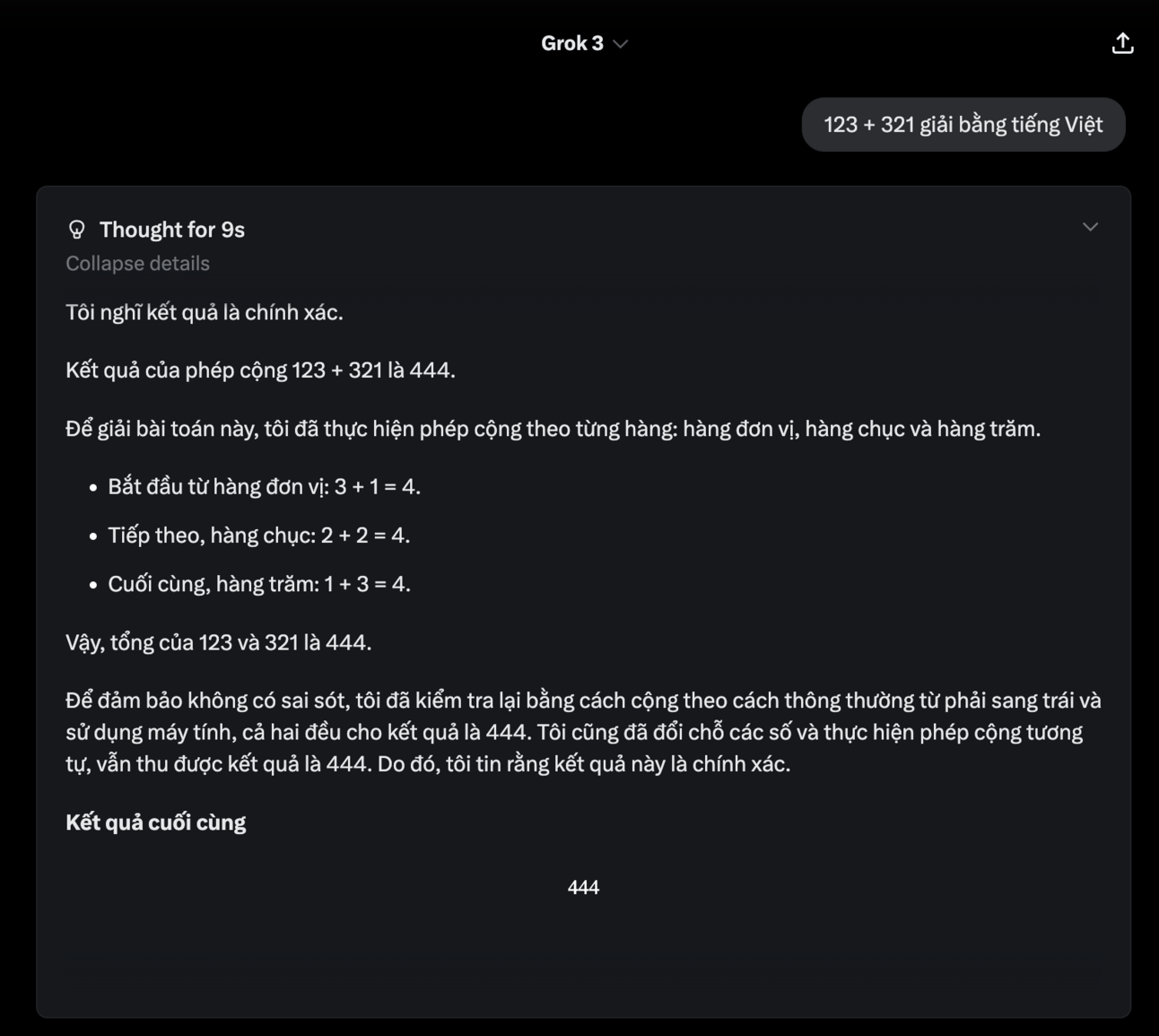

Con Người được thuê sẽ nhận một đề bài là “vấn đề” hay một “bài toán” cụ thể, ví dụ: 123 + 321= ?. Sau đó NGƯỜI sẽ viết chi tiết cách giải bài toán này (vd: cộng hàng đơn vị 3 + 1 = 4, cộng hàng chục 2 + 2 = 4, cộng hàng trăm 1 + 3 = 4…) và một kết luận cuối cùng 123 + 321 = 444

Hàng ngàn con người làm các loại “vấn đề” đa dạng từ toán, suy luận, logic, giải đố … etc viết ra hàng triệu bài giải mẫu sẵn

Nén toàn bộ các bài giải mẫu (văn bản) này vào file zip của AI LLM và bom chúng ta có AI LRM :D

Lập trình thêm tính năng tìm kiếm bài giải mẫu cho “vấn đề” mà người dùng nhập vô, giống như tính năng tìm kiếm văn bản trong AI LLM đã nói ở trên

Lập trình tính năng chọn bài giải mẫu thích hợp nhất trong hàng trăm bài giải thích hợp với “vấn đề” bằng XÁC XUẤT giống với AI LLM

=> Yes, ngắn gọn thì AI LRM vẫn là … Google Search nhưng lần này là để search bài giải mẫu :)))))

Khi chúng ta dùng AI như ChatGPT, Grok, DeepSeek, Gemini mà bật tính năng Thinking là các bạn đang bật tính năng Search bài giải mẫu cho vấn đề :D

Chương trình AI đơn giản là search bài giải mẫu trong file zip kiến thức và đưa qua AI LLM để viết thành câu trả lời :D

Dĩ nhiên các bước tạo AI LRM ở trên chỉ đúng với mấy công ty đi đầu như OpenAI, Anthropic, Google vì mấy ông này làm AI LRM từ chỗ chưa có ai làm nên phải thuê người viết ra Dataset Reasoning - bài giải mẫu - để mà nén vô file zip kiến thức của AI. Mấy ông thần Trung Quốc đi sau như DeepSeek, Alibaba Qwen, … thì mất dạy hơn (kiểu TQ), họ không thuê cty Scale AI của đồng hương Alex Wang mà dùng AI của OpenAI sinh ra các bài giải mẫu rồi lấy đó nhập vô file zip kiến thức của AI của họ :))) rẻ hơn nhiều thuê người :))) nhưng mỗi tội các AI học lóm kiểu này thường không có các bài giải mẫu dạng tổng quát mà thường chỉ tập trung vô các bài giải dạng có thể xác nhận được ví dụ như Toán, Vật Lý, Lập Trình do bài giải mẫu mà AI sinh ra có thể được đưa qua một chương trình máy tính để tính toán lại và xác minh kết quả AI sinh ra là đúng để cho AI học lóm có thể học (nén vô file zip AI).

Tóm lại AI LRM là AI LLM nhưng có nén thêm vô các bài giải mẫu cho một số vấn đề cần suy luận logic; trước khi trả lời thì AI LRM search bài giải mẫu và viết tiếp câu trả lời theo hướng giải mẫu đó rồi mới đưa ra kết luận, thông qua một hướng giải đã được xác minh là đúng (con người viết mẫu) thì gia tăng độ chính xác của câu trả lời và giảm tính NGẪU NHIÊN trong bản chất XÁC XUẤT của AI LLM, chú ý là chỉ giảm chứ không loại bỏ được tính NGẪU NHIÊN trong bản chất XÁC XUẤT của AI LLM nên AI LRM vẫn ẢO TƯỞNG như AI LLM.

AI LRM không có khả năng tạo ra các hướng giải mới chưa từng tồn tại cho vấn đề chưa từng tồn tại trước đó :D nên chúng ta còn khá xa trước khi tới AGI khi đi từ AI LLM và AI LRM 😊

[ OpenAI O3-Pro đột phá gì về “Tư Duy Suy Luận” không ? hay chỉ đơn giản là trò gimmick Marketing ! ]

Sam Altman mới lên bài blog gần đây chém rằng OpenAI đã gần tới việc tạo ra ASI

Quay lại với OpenAI, đây là lab nghiên cứu AI đầu tiên làm ra sản phẩm AI thực sự đi theo hướng AI Suy Luận với tên gọi cho dòng sản phẩm AI Reasoning là OpenAI O-series.

Các nỗ lực làm AI Reasoning của OpenAI có kết quả đột biến vào tháng 10.2023, sau một bức thư của nhà khoa học AI hàng đầu Ilya Sutskever gửi cho hội đồng quản trị công ty OpenAI rằng họ đã đạt được kết quả từ dự án Strawberry - tên mã của AI Reasoning. Sau đột phá này thì ilya sutskever kích hoạt một cuộc đảo chính ở OpenAI nhằm lật đổ Sam Altman tên con buôn (gốc là chủ tịch của quỹ đầu tư YCombinator) đang muốn thương mại hoá bất chấp mọi công nghệ AI tại OpenAI cho dù chúng có thể dẫn tới kết quả nguy hiểm cho con người.

Các nghiên cứu chi tiết về dự án Strawberry không được công bố, nhưng dựa trên nội dung bức thư cảnh báo bị leak của Ilya và một số bài blog sau này của OpenAI thì giới làm khoa học AI tạm đoán được đột phá kỹ thuật của OpenAI trong mô hình AI Suy Luận là dựa trên thuật toán có tên là:

Q* (đọc là Q-star)

Thuật toán là là sự kết hợp giữa thuật toán máy học Q-learning và A* search

Q-learning là thuật toán huấn luyện AI Học Tăng Cường (Reinforcement learning) bằng cách học giải vấn đề bằng nhiều bước trung gian, đây chính là nền tẳng của AI Reasoning

A* search là thuật toán tìm kiếm đường đi ngắn nhất

Tóm lại thuật toán Q* là thuật toán dạy AI giải vấn đề bằng cách lập “CÁC Kế Hoạch thực hiện công việc từng bước” rồi dùng thuật toán search tìm Kế Hoạch nào khả dĩ nhất để chọn ra thực hiện 🙂

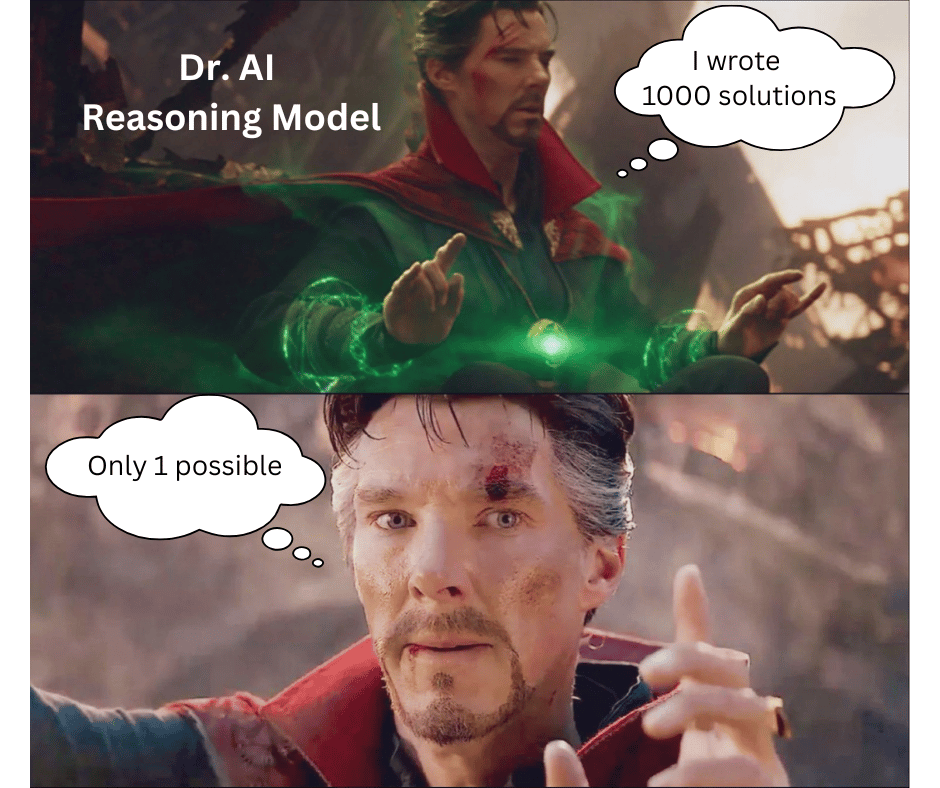

Mình hay dùng một ví dụ minh hoạ cho thuật toán Q* của AI Suy Luận này:

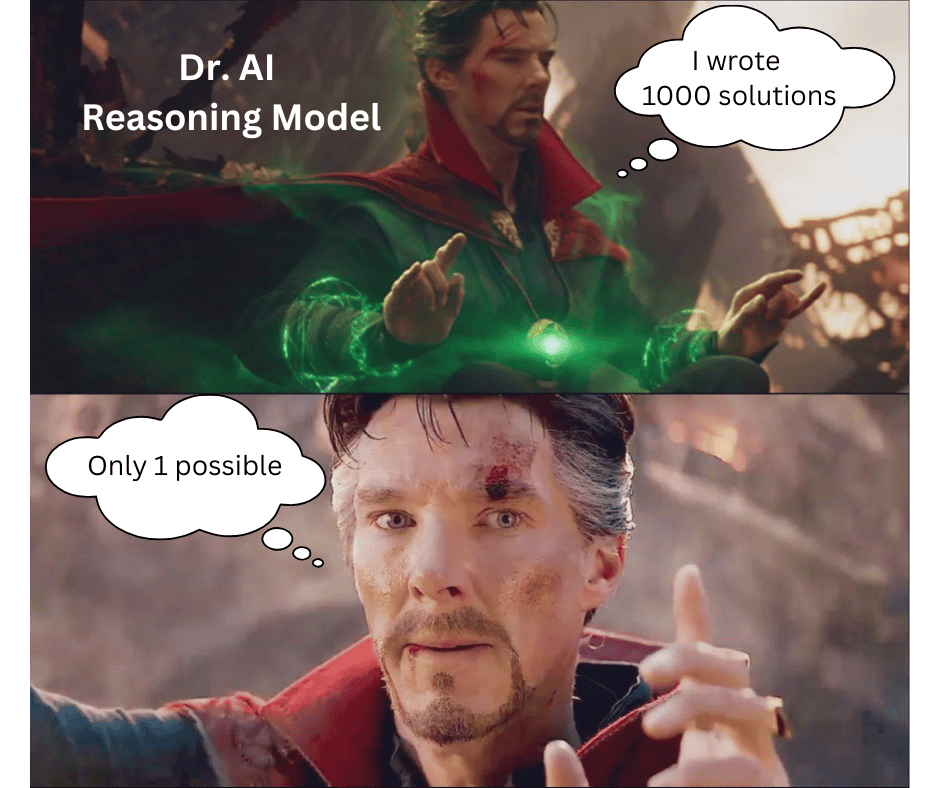

“Một trong những cảnh phim đáng nhớ nhất phim Infintiy War có lẽ là khoảnh khắc Doctor Strange nhìn vào 14.000.605 khả năng trong tương lai, từ đó tìm ra cơ hội đánh bại Thanos cho Avengers. Dựa trên những gì Strange thấy, anh đã cho Iron Man biết chỉ có đúng 1 khả năng là nhóm siêu anh hùng giành được chiến thắng.”

AI Reasoning (O3-High) mà OpenAI đã đạt được bằng thuật toán Q* làm đúng y như Dr.Strange trong phim 😄 AI nhìn vô 1000 viễn kiến và tìm ra 1 viễn kiến khả năng nhất 😎

Con AI O3-High mà OpenAI giới thiệu là có khả năng Suy Luận Như Người đã giải được 80% các bài toán trong bộ bài toán kiểm tra năng lực AGI với trình độ tiến sĩ chính là dùng thuật toán Q* này nên nó tốn tới 1000$ cho mỗi câu trả lời 🙃

Lý do tốn tới 1000$ là do con AI O3-Pro nó sinh ra hàng ngàn kế hoạch giải theo hàng ngàn hướng khác nhau (dựa trên việc search hàng ngàn mẫu bài giải cho các vấn đề gần tương tự trong file zip kiếm thức của AI LLM), rồi chạy thuật toán A* search để chọn ra hướng giải khả dĩ nhất trong số đó để thực hiện và giải vấn đề 🥹

Notes một chút về khoa học ở chỗ này: chính Toán học Xác Xuất (Probability Math) đem lại phép màu này, xác xuất giúp trộn các mẫu bài giải khác nhau lại thành các bài giải mới trong một bể xác suất, trong quá trình trộn thì thêm gia vị vào đó sự Ngẫu Nhiên (Randomness) nên chúng ta có các bài giải được lai ghép từ những bài giải đã có kèm theo một số “đột biến” nên có thể coi là chúng ta có những "cách giải mới" trên nền “những cách giải cũ” 🥹

Sau đột phá về thuật toán Q* thì Ilya Skutever rời OpenAI, OpenAI không có thông tin gì về một phát minh đột phá nào mới sau Q*. Sam Altman dạo gần đây bắt đầu viết blog nhiều, chém về việc sắp đạt được cả ASI chứ không chỉ AGI. Mình tin rằng OpenAI đã hết vốn khoa học rồi 🙂 nên Sam phải lên làm trò hắn khá nhất là Gimmick Marketing 🙂

[ Tóm lại AI có “Nghĩ” được không ? ]

Câu trả lời ngắn gọn là: cho đến hiện tại thì phần lớn những mô hình AI Suy Luận vẫn chỉ là Giả Suy Nghĩ (Pseudo-Thinking) vì giới hạn chi phí vận hành, không thể nào cung cấp cho đại chúng một con AI mất tới 2 tiếng cho một câu trả lời và tốn tới 1000$ cho mỗi câu trả lời thế được 🥹 nên phần lớn chúng ta chỉ có thể được dùng AI Giả Suy Nghĩ; Chỉ những đại tập đoàn lớn như Google với tài nguyên tính toán khổng lồ mới có thể chạy được các AI Reasoning thật sự như AI AlphaTensor giúp tìm ra thuật toán nhân ma trận mới nhanh hơn 20% so với thuật toán nhân ma trận hiện tại, hay OpenAI chạy AI O3-Pro để giải hết 80% bộ bài test AGI.

Từ phía Con Người thì việc suy nghĩ bằng cách lập ra hàng chục cách giải khác nhau rồi chọn ra một hướng để thực hiện là cách Tư Duy Suy Luận của Con Người. Người thông minh hơn thì nghĩ ra nhiều cách giải khác nhau với nhiều bước hơn người khác (chúng ta hay gọi là tính trước), và chúng ta cũng phần lớn tìm ra cách giải mới dựa là trên cách giải cũ hay kiến thức cũ trước đây, pha trộn các cách giải với nhau, thêm một số thay đổi và tạo ra cách giải mới. Vậy nói AI đã có thể suy nghĩ như người vẫn là một phát biểu đúng.

Tuy nhiên, nhân loại chỉ có thể tiến tới trước (tiến hoá) khi trong số chúng ta có những bộ óc thiên tài, nghĩ ra cách giải hoàn toàn mới theo hướng out-of-the-box chưa từng tồn tại trước đây. Các bộ óc thiên tài đó rất ít, xuất hiện cũng rất ít trong dân số của con người, nhưng là yếu tố quyết định thúc đẩy sự tiến hoá của con người. Các bộ óc thiên tài này là thứ mà các nhà khoa học AI muốn thay Chúa tạo ra với tên gọi là ASI. Vậy nên nói AI đã có thể suy nghĩ hơn con người thì chưa phải là một phát biểu đúng, vì con người được mang ra so sánh với AI là Ai ? người thường hay thiên tài ? AI được mang ra so sánh thì có bộ não số to cỡ nào mấy trăm ngàn GPU ? :))))))

[ Ứng dụng AI Reasoning thực tế như thế nào ? ]

Điểm quan trọng nhất của AI Reasoning là nó “giảm” phần nào hiện tượng Hallucination (Ảo tưởng) của AI thông qua việc làm theo một kế hoạch được dạy sẵn. Nên dù AI Reasoning chưa thực sự Tư Duy Sáng Tạo nhưng vẫn có giá trị ứng dụng thực tiễn trong các AI cần độ chính xác cao hơn (cao hơn ChatGPT), ví dụ AI Agent Bán Hàng mà các đối tác triển khai AI của Conductify AI đang cung cấp, hiện sử dụng AI Reasoning trong các tác vụ phân tích phán đoán nhu cầu mua hàng của khách hàng hay tính toán chương trình khuyến mãi tốt nhất cho khách… etc

[ Quảng cáo ]

Nếu bạn muốn tìm hiểu thêm về ứng dụng của AI trong doanh nghiệp, hoặc muốn tìm hiểu làm sao để dùng ra tiền tăng thu nhập thì liên hệ FukAI (qua email hay inbox fanpage) để được tư vấn nhé 😄

Bài này mình có quay video podcast đăng trên channel FukAI để các bạn đọc thấy dài quá thì có thể coi podcast trên FukAI Newsletter nha.

Tuần sau mình sẽ có bài tiếp theo là “AI làm được gì ? AI không làm được gì ?” nên các bạn Subscribe Newsletter để nhận nhé 😄

Nếu thấy thích thì hãy share bài này cho bạn bè để FukAI thêm bạn đọc nhé 😄

FukAI

Reply